Fonte: E-bookBigDataV2.pdf (Este arquivo é liberado depois de concluído o curso de Big Data) Aproveito a oportunidade para agradecer ao excelente trabalho no desenvolvimento do conteúdo deste E-book, recomendo fazerem o curso de Big Data para atualizarem-se.

Cerca

de 90% de todos os dados gerados no planeta, foram gerados nos

últimos 2 anos.

Aproximadamente

80% dos dados são não-estruturados ou estão em diferentes

formatos, o que dificulta a análise. Modelos de análise de dados

estruturados, possuem limitações quando precisam tratar grandes

volumes de dados.

Muitas

empresas não sabem que dados precisam ser analisados Muitas empresas

nem mesmo sabem que os dados estão disponíveis Dados preciosos são

descartados por falta de conhecimento ou ferramentas de tratamento. É

caro manter e organizar grandes volumes de dados não-estruturados.

Estamos

em um período de transformação no modo em que dirigimos nossos

negócios e, principalmente, as nossas vidas. Neste exato momento,

uma verdadeira enxurrada de dados, ou 2.5 quintilhões de bytes por

dia, é gerada para nortear indivíduos, empresas e governos, e está

dobrando a cada dois anos. Toda vez que fazemos uma compra, uma

ligação ou interagimos nas redes sociais, estamos produzindo esses

dados. E com a recente conectividade em objetos, tal como relógios,

carros e até geladeiras, as informações capturadas se tornam

massivas e podem ser cruzadas para criar roadmaps cada vez mais

elaborados, apontando e, até prevendo, o comportamento de empresas e

clientes. Entre 2005 e 2020, o universo digital irá crescer de 130

exabytes para 40.000 exabytes ou 40 trilhões de gigabytes. Em 2020,

haverá 5.200 gigabytes para cada homem, mulher e criança no planeta

Até 2020, o universo digital irá dobrar de tamanho a cada 2 anos. A

revolução não está nas máquinas que calculam os dados e sim nos

dados em si e na maneira que são utilizados.

AFINAL,

O QUE É BIG DATA?

Big Data é uma coleção de conjuntos

de dados, grandes e complexos, que não podem ser processados por

bancos de dados ou aplicações de processamento tradicionais.

Capacidade de uma sociedade de obter

informações de maneiras novas a fim de gerar ideias úteis e bens e

serviços de valor significativo. O Google estima que a humanidade

criou nos últimos 5 anos, o equivalente a 300 Exabytes de dados ou

seja:

300.000.000.000.000.000.000 bytes de

dados.

Podemos

definir o conceito de Big Data como sendo conjuntos de dados

extremamente amplos e que, por este motivo, necessitam de ferramentas

especialmente preparadas para lidar com grandes volumes, de forma que

toda e qualquer informação nestes meios possa ser encontrada,

analisada e aproveitada em tempo hábil.

De

maneira mais simplista, a ideia também pode ser compreendida como a

análise de grandes quantidades de dados para a geração de

resultados importantes que, em volumes menores, dificilmente seriam

alcançados. No mundo do Big Data, por sua vez, não temos de nos

fixar na causalidade; podemos descobrir padrões e correlações nos

dados que nos propiciem novas e valiosas ideias.

Muitos

dos dados gerados, possuem um tempo de vida curto e se não

analisados, perdem a utilidade. Dados são transformados em

informação, que precisa ser colocada em contexto para que possa

fazer sentido. É caro integrar grandes volumes de dados

não-estruturados. Dados potencialmente valiosos em sistemas ERP, CRM

ou SCM são descartados ou perdidos apenas porque ninguém presta

atenção neles.

QUAL

O TAMANHO DO BIG DATA?

IMPORTÂNCIA

DO BIG DATA

-

Porque surgiram tecnologias que

permitem processar esta grande quantidade de dados de forma

eficiente e com baixo custo.

-

Os dados podem ser analisados em seu

formato nativo, seja ele estruturado, não estruturado ou Streaming (fluxo constante de dados).

-

Dados podem ser capturados em tempo

real.

-

Dados podem ser transformados em

insights de negócios.

DESAFIOS

Encontrar profissionais habilitados em

Big Data. Compreender as plataformas e ferramentas para Big Data.

Coletar, armazenar e analisar dados de

diferentes fontes, em diferentes formatos e gerados em diferentes

velocidades.

Migrar do sistema tradicional de

coleta e armazenamento de dados, para uma estrutura de Big Data.

OS

4 V’S DO BIG DATA

VOLUME:

Tamanho dos dados

VELOCIDADE:

Na geração de dados

VARIEDADE:

Do formato dos dados

VERACIDADE:

Confiabilidade dos dados

Espera-se

que 40 zettabytes de dados sejam criados até 2020 no mundo;

Cerca

de 2.5 quintillionbytes de dados são criados por dia;

Existem

atualmente cerca de 6 bilhões de telefones móveis no planeta;

Cada

empresa americana armazena cerca de 100 Terabytes de dados.

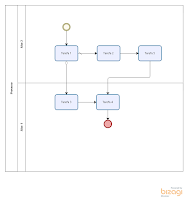

Existem

programas como o

NoSql, que fazem as tratativas dos dados no Big Data com muita rapidez e alta escalabilidade, sendo o

NoSql

uma classe de bancos de dados que diverge do modelo de

sistema de gerenciamento de bancos de dados relacionais – não fazendo uso

primário de tabelas e não usando, no geral, declarações SQL para efetuar a

manipulação de dados. Para introduzir estas novas ferramentas não podemos esquecer que deverá haver um mapeamento de processos, gerenciamento de mudanças, gerenciamento de nível de acordo de serviços, analisando o quanto esta mudança vai afetar os serviços acordados, gestão de riscos, analisando os riscos iminentes da mudança, e, o gerenciamento de configuração de ativos e serviços, avaliando o que vai mudar nas configurações de hardware e software.

Grato,