Fonte:

E-bookBigDataV2.pdf (Este arquivo é liberado depois de concluído o

curso de Big Data) Aproveito a oportunidade para agradecer ao

excelente trabalho no desenvolvimento do conteúdo deste E-book,

recomendo fazerem o curso de Big Data para atualizarem-se.

O

hadoop está se tornando o padrão nos projetos de Big Data porque

possui:

•

Livre.

•

Baixo custo.

•

Tolerância a falhas a recuperação

automática.

•

Portabilidade entre hardware e

sistemas operacionais heterogêneos.

•

Escalabilidade para armazenar e

processar grandes quantidades de dados.

•

Confiabilidade, através da manutenção

de várias cópias de dados, e, permite que os jobs sejam executados

em paralelo e em caso de falhas de um job, outros não são afetados.

•

Flexibilidade – processa todos os

dados independente do tipo e formato, seja estruturado ou

não-estruturado.

•

Acessibilidade – suporte a diversas

linguagens de programação como Java, C++, Python, Apache Pig.

Componentes

Base do Hadoop: Hadoop HDFS + Hadoop MapReduce

Onde:

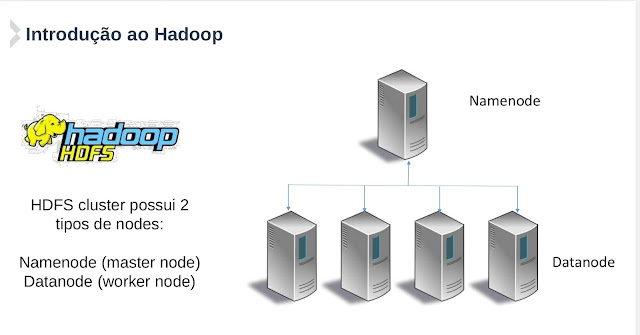

HDFS:

Armazenamento distribuído. Foi desenvolvido utilizando o projeto do

sistema de arquivos distribuídos (DFS). Ele é executado em hardware

commodity (baixo custo). Ao contrário de outros sistemas

distribuídos, HDFS é altamente tolerante a falha.

CARACTERÍSTICAS

DO HDFS

•

DFS (Distributed File System) - foi

criado para gestão de armazenamento em uma rede de computadores.

•

HDFS é otimizado para armazenar

grandes arquivos.

•

HDFS foi pensado para executar em

clusters de computadores de baixo custo.

•

HDFS foi pensado para ser ótimo em

performance do tipo WORM (Write Once, Read Many Times), que é um

eficiente padrão de processamento de dados.

•

HDFS foi pensando considerando o tempo

de leitura de um conjunto de dados inteiro e não apenas o primeiro

registro.

COMO

É CONFIGURADO O HADOOP

MapReduce: Computação distribuída

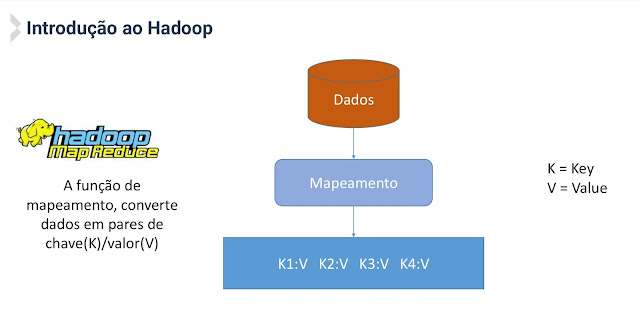

• MapReduce é um modelo de programação para processamento e geração de grandes conjuntos de dados.

• MapReduce transforma o problema de análise em um processo computacional que usa conjuntos de chaves e valores.

• MapReduce foi desenvolvido para tarefas que consomem minutos ou horas em computadores conectados em rede de alta velocidade gerenciados por um único master.

• MapReduce usa um tipo de análise de dados por força bruta. Todo o conjunto de dados é processado em cada query.

• MapReduce permite a execução de queries ad-hoc em todo o conjunto de dados em um tempo escalável.

• Muitos sistemas distribuídos combinam dados de múltiplas fontes (o que é bem complicado), mas MapReduce faz isso de forma eficiente e efetiva.

• O segredo da performance do MapReduce, está no balanceamento entre seeking e transfer: reduzir operações de seeking e usar de forma efetiva as operações de transfer.

Seek time – é o delay para encontrar um arquivo.

Transfer rate – é a velocidade para encontrar o arquivo. Transfer rates tem melhorado significativamente (é bem mais veloz que Seek times).

• O MapReduce é bom para atualizar todo (ou a maior parte) de um grande conjunto de dados.

• RDBMS (Relational Database Management System) são ótimos para atualizar pequenas porções de grandes bancos de dados.

• RDBMS utiliza o tradicional B-Tree, que é altamente dependente de operações de Seek.

• MapReduce utiliza operações de SORT e Merge para recriar o banco de dados, o que é mais dependente de operações de transfer.

O MapReduce se baseia em operações de transfer, o que deixa o acesso aos dados muito mais veloz.

COMO

TRABALHA O MAPREDUCE

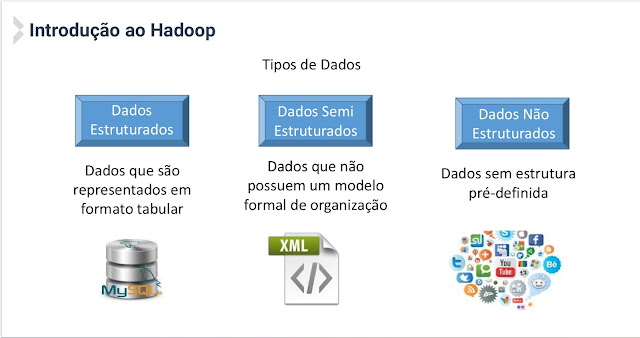

TIPOS

DE DADOS

MapReduce é muito efetivo com dados semi ou não estruturados, porque MapReduce interpreta dados durante as sessões de processamento de dados. Ele não utiliza propriedades intrínsecas. Os parâmetros usados para selecionar os dados, são definidos pela pessoa que está fazendo a análise.

Informação Importante: Hadoop não é um banco de dados. Hadoop é um framework para armazenamento e processamento de grandes conjuntos de dados.

Depois de ler o artigo, responda a seguinte enquete.

Veja Também:

A teoria da relatividade e a Informática

Grato,

Jefferson Daminelli Garcia

Depois de ler o artigo, responda a seguinte enquete.

Veja Também:

A teoria da relatividade e a Informática

Grato,

Jefferson Daminelli Garcia